Kst179 (обсуждение | вклад) Нет описания правки Метки: Визуальный редактор apiedit |

Метки: Визуальный редактор apiedit |

||

| (не показана 1 промежуточная версия 1 участника) | |||

| Строка 23: | Строка 23: | ||

== ROC-кривая для оценивания вероятностей случайным образом == |

== ROC-кривая для оценивания вероятностей случайным образом == |

||

| + | {{Сомнения|Что непонятно? = Экзамен показал, что здесь, похоже, всё неверно, а спрашивают часто. Якобы где-то решалась на семинарах.}} |

||

| ⚫ | |||

| + | |||

| ⚫ | Если классификатор выдает вероятность равную <math>p(x) = \xi</math>, где <math>\xi</math> - равномерно распределенная на отрезке [0, 1] случайная величина, то ROC-кривая такого классификатора будет совпадать с графиком <math>y=x</math>, то есть для любого порога <math>\mu: TPR(\mu) = FPR(\mu)</math> (если более формально, то это верно только для матожиданий TPR и FPR, так как <math>\xi</math> случайная величина, и если нам ооочень повезет, то разделение может быть идеальным, а ROC-кривая пройдет через точку (0, 1)). |

||

| + | |||

| + | Зафиксируем некий порог <math>\mu</math>. Тогда <math>\xi < \mu</math> с вероятностью <math>\mu</math> и <math>\xi \geqslant \mu</math> с вероятностью <math>1-\mu</math>. Пусть в выборке <math>N^+</math> объектов положительного класса, и <math>N^-</math> отрицательного. Тогда <math>\mathbb{E}TP = (1-\mu)N^+, \mathbb{E}FP = (1-\mu)N^-, \mathbb{E}FN = \mu N^+, \mathbb{E}TN = \mu N^-</math>. А значит <math>\mathbb{E}TPR = \mathbb{E}\frac{TP}{TP+FN} = \frac{(1-\mu)N^+}{(\mu + 1-\mu) N^+} = 1-\mu= </math><math>= \frac{(1-\mu)N^-}{(\mu + 1-\mu) N^-} = \mathbb{E}\frac{FP}{FP+TN} = \mathbb{E}FPR.</math> |

||

Текущая версия от 18:08, 15 января 2017

TPR и FPR[]

Рассмотрим случай бинарной классификации (). Пусть - классификатор, который оценивает вероятность принадлежности объекта к положительному классу. Рассмотрим некоторый порог , по которому будем строить предсказание. Отнесем объект x к положительному классу, если , иначе — к отрицательному. Построим для него матрицу ошибок и найдем значения и введем две метрики:

- True positive rate: .

- False positive rate: .

TPR полностью совпадает с полнотой, и показывает долю верно предсказанных классов у объектов, относящихся к положительному классу.

FPR — это доля неправильно предсказанных классов среди объектов отрицательного класса.

Кривая ошибок (ROC-curve)[]

Так как TPR и FPR считались для фиксированного порога то их можно представить в виде функций от аргумента : . При этом обе функции монотонно возрастают от до , а значит определена функция:

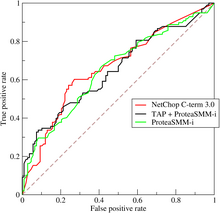

ROC-кривые для разных методов

(более формально: ).

Которая называется рабочей характеристикой приемника (reciever operation characteristic, ROC). График функции называется ROC-кривой или кривой ошибок.

- Всегда начинается в и заканчивается в .

- Как правило, у хорошего классификатора кривая лежит по большей части, либо целиком выше прямой . Это связано с тем что при хорошей классификации надо получать максимальный при минимальном .

см. также AUC-ROC

Метод построения ROC-кривой[]

Пусть классификатор выдает на выборке вероятности соответственно. Отсортируем вероятности в порядке возрастания: , и этим вероятностям соответствуют объекты и метки классов соответственно. Разобьем квадрат на координатной плоскости на клеток по горизонтали и клеток по вертикали (где — количество объектов положительного класса, — количество объектов отрицательного класса). Начнем рисовать ROC кривую из точки и последовательно перебирать метки классов, начиная с до : если то рисуем вертикальный отрезок на одну клетку вверх, иначе горизонтальный отрезок на одну клетку вправо. Очевидно, в таком случае мы закончим ROC-кривую в точке и она будет отображать зависимость .

ROC-кривая для оценивания вероятностей случайным образом[]

| DANGER! Это место вызывает сомнения или непонимание! Экзамен показал, что здесь, похоже, всё неверно, а спрашивают часто. Якобы где-то решалась на семинарах. |

|

Если классификатор выдает вероятность равную , где - равномерно распределенная на отрезке [0, 1] случайная величина, то ROC-кривая такого классификатора будет совпадать с графиком , то есть для любого порога (если более формально, то это верно только для матожиданий TPR и FPR, так как случайная величина, и если нам ооочень повезет, то разделение может быть идеальным, а ROC-кривая пройдет через точку (0, 1)).

Зафиксируем некий порог . Тогда с вероятностью и с вероятностью . Пусть в выборке объектов положительного класса, и отрицательного. Тогда . А значит

![{\displaystyle \mu \in [0,1]}](https://services.fandom.com/mathoid-facade/v1/media/math/render/svg/d8aa084a430beb1ceec4611c8d51768dc19cb678)

![{\displaystyle ROC(x)=TPR(FPR^{-1}(x)),x\in [0,1]}](https://services.fandom.com/mathoid-facade/v1/media/math/render/svg/26ff70f530fcee64c8c86ff7af3955b191bc98b0)

![{\displaystyle [0,1]\times [0,1]}](https://services.fandom.com/mathoid-facade/v1/media/math/render/svg/458bdc500fce0890dd0bda5865fb50449a0ce710)